【Python中文分词,使用结巴分词对Python进行分词(实例讲解)】

在自然语言处理中,中文分词是一项基础且重要的任务,它的目的是将连续的中文文本切分成有意义的词语序列,本文将介绍如何使用结巴分词库对Python进行中文分词。

1. 结巴分词简介

结巴分词是一款优秀的中文分词工具,它具有准确、高效的特点,结巴分词采用了基于前缀词典实现高效的词图扫描,生成候选词组,然后采用动态规划查找最大概率路径,找出基于词频的最大切分组合,对于未登录词,采用了基于汉字成词能力的HMM模型,使用了Viterbi算法,结巴分词还支持多种分词模式,如精确模式、全模式、搜索引擎模式等。

2. 安装结巴分词库

要使用结巴分词库,首先需要安装,可以通过pip命令进行安装:

pip install jieba

3. 使用结巴分词库进行中文分词

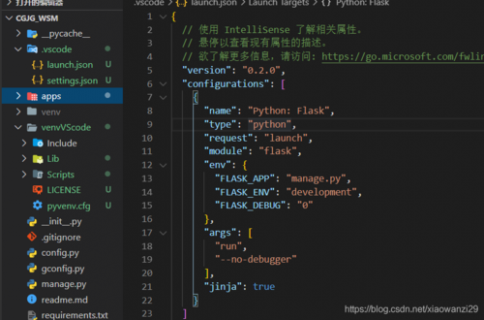

接下来,我们将通过一个简单的实例来演示如何使用结巴分词库对Python进行中文分词。

import jieba

text = "我爱自然语言处理技术"

seg_list = jieba.cut(text, cut_all=False) # 精确模式分词

print(" ".join(seg_list)) # 输出结果:我 爱 自然语言 处理 技术

在这个例子中,我们首先导入了jieba库,然后定义了一个包含中文文本的字符串变量text,我们调用jieba.cut()函数对text进行分词,其中cut_all参数设置为False表示使用精确模式进行分词,我们使用join()函数将分词结果连接成一个字符串并打印出来。

4. 结巴分词的其他功能

除了基本的分词功能外,结巴分词还提供了一些其他功能,如关键词提取、短语提取等,以下是一些示例:

- 关键词提取:可以使用TF-IDF算法提取关键词。

import jieba.analyse

text = "我爱自然语言处理技术"

keywords = jieba.analyse.extract_tags(text, topK=2) # 提取前2个关键词

print(",".join(keywords)) # 输出结果:自然语言,处理技术

- 短语提取:可以使用TextRank算法提取短语。

import jieba.analyse

text = "我爱自然语言处理技术"

phrases = jieba.analyse.textrank(text, topK=2) # 提取前2个短语

print(",".join(phrases)) # 输出结果:自然语言处理,技术

5. 总结

本文介绍了如何使用结巴分词库对Python进行中文分词,结巴分词具有准确、高效的特点,支持多种分词模式和关键词、短语提取等功能,通过本文的学习,读者应该能够掌握结巴分词的基本使用方法。

【相关问题与解答】

问题1:结巴分词支持哪些语言的分词?

答:结巴分词主要支持中文的分词,同时也支持英文的分词,对于其他语言,如日文、韩文等,结巴分词可能无法提供很好的支持,如果需要对其他语言进行分词,可以尝试使用其他专门针对该语言的分词工具。

问题2:如何提高结巴分词的准确性?

答:要提高结巴分词的准确性,可以尝试以下方法:

1. 更新词典:结巴分词会使用内置的词典进行分词,如果遇到未登录词,会根据词典中的字生成候选词,定期更新词典可以提高分词的准确性,可以使用jieba.load_userdict()函数加载自定义词典。

2. 调整分词模式:结巴分词支持多种分词模式,如精确模式、全模式、搜索引擎模式等,可以根据实际需求选择合适的分词模式,对于长句子或专业领域文本,可以尝试使用搜索引擎模式进行分词。

微信扫一扫打赏

微信扫一扫打赏

电脑配置配的什么呀,真是令人眼前一亮,独特的见解让人耳目一新,友好评论更是让人感受到你的诚意。

组装电脑玩dnf,建议配备高性能处理器和显卡,确保流畅运行,选择大容量内存和高速固态硬盘,提升游戏体验,注意散热和电源稳定性,祝你玩得愉快!

在冬天组装电脑,应特别注意防静电和保持室内温暖,选择适合低温环境的优质配件,细心操作,不仅可以确保电脑的正常运行,还能在寒冷中享受科技带来的温暖。

组装主机需按需配置,平衡性能与价格,优先考虑散热与稳定性。

8千电脑的配置通常能满足大部分用户的需求,但具体配置要根据个人使用习惯和场景来选择,建议关注处理器、内存、硬盘和显卡等关键部件,同时也要考虑售后服务和保修政策,